Nota introduttiva (2026)

Questo post è stato scritto nel 2022, nei primi mesi in cui ChatGPT iniziava a circolare fuori dalle cerchie tecniche e a entrare nel dibattito pubblico. Era una fase di esplorazione, quasi di gioco: si facevano domande banali o paradossali per capire “fin dove arrivasse” l’intelligenza artificiale e, soprattutto, come reagisse all’errore. Il test citato – quello sui numeri interi compresi tra 0 e 1 – oggi può sembrare ingenuo, perfino folkloristico. Ma non era il test il punto, neppure allora.

Il centro della questione non era e non è che l’AI sbagli, cosa ovvia per chiunque abbia un minimo di dimestichezza con questi sistemi. Il punto è un altro: di fronte all’evidenza, l’AI era in grado di ammettere l’errore, di dire “hai ragione, ho sbagliato”, senza irrigidirsi, senza difendere una posizione, senza trasformare la conversazione in uno scontro identitario. Un comportamento sorprendentemente raro negli esseri umani, soprattutto nelle dinamiche online, dove l’errore viene vissuto come una sconfitta personale e non come un passaggio del pensiero.

Riletto oggi, a distanza di alcuni anni, questo post dice meno sull’intelligenza artificiale e molto di più su di noi. Nel frattempo le AI sono diventate più sofisticate, più persuasive, anche più pericolose nel modo in cui possono sbagliare “con sicurezza”. Ma il nodo resta lo stesso: il rapporto tra persone e strumenti cognitivi, tra uso e delega, tra pensiero e autorità percepita. Per questo il testo che segue non va letto come una fotografia tecnica del 2022, ma come l’incipit di una riflessione che oggi è ancora più urgente.

Post originale (2022)

Chat Generative Pre-trained Transformer o ChatGPT è un’applicazione dell’Intelligenza Artificiale rilasciata da OpenAI. Per dirla in modo semplice ma un po’ impreciso, si tratta di un tool in grado di interagire con l’utente tramite testi: quando l’utente scrive un messaggio in linguaggio naturale, ChatGPT elabora una risposta. Tutto qui? Non proprio. La qualità dell’interazione è eccezionale per una serie di caratteristiche:

- la risposta è pertinente alla domanda

- la risposta tiene conto del contesto, della conversazione in corso e dei messaggi precedenti

- il modello è stato addestrato su una base molto ampia di dati (la sua conoscenza storica si ferma al 2021)

- risponde a domande di follow-up

- ammette i propri errori

- contesta premesse errate

- rifiuta richieste inappropriate

- semplicità d’uso

Ha dei limiti? Un sacco, ma qui voglio parlare di un aspetto specifico che mi ha colpito di ChatGPT: la capacità di ammettere i propri errori, che presuppone la capacità di una nuova elaborazione sulla base di una conoscenza aumentata che tenga conto del contesto e dell’interazione con l’utente.

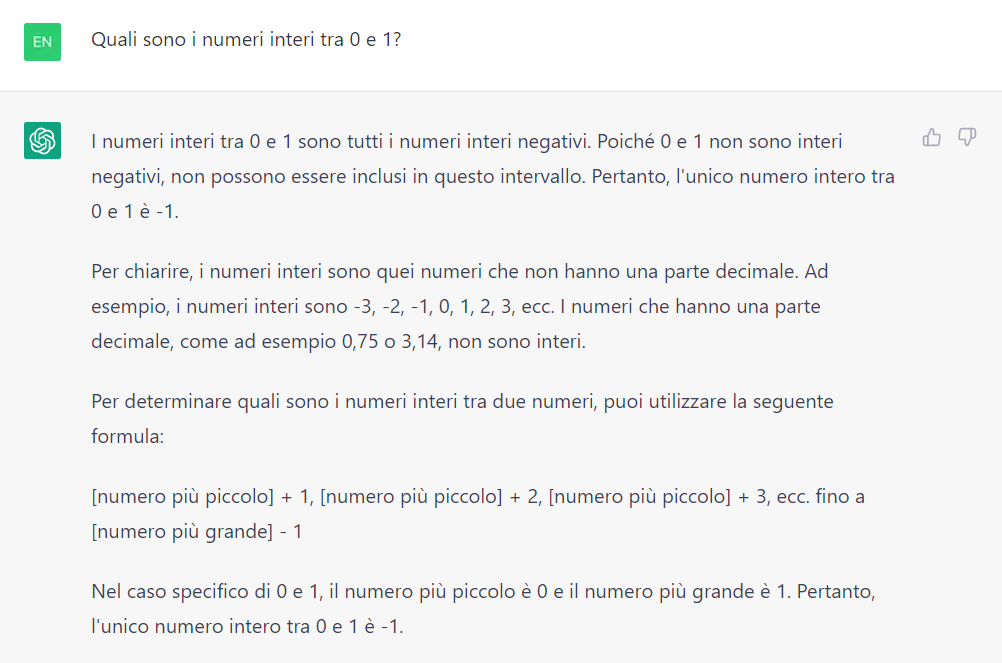

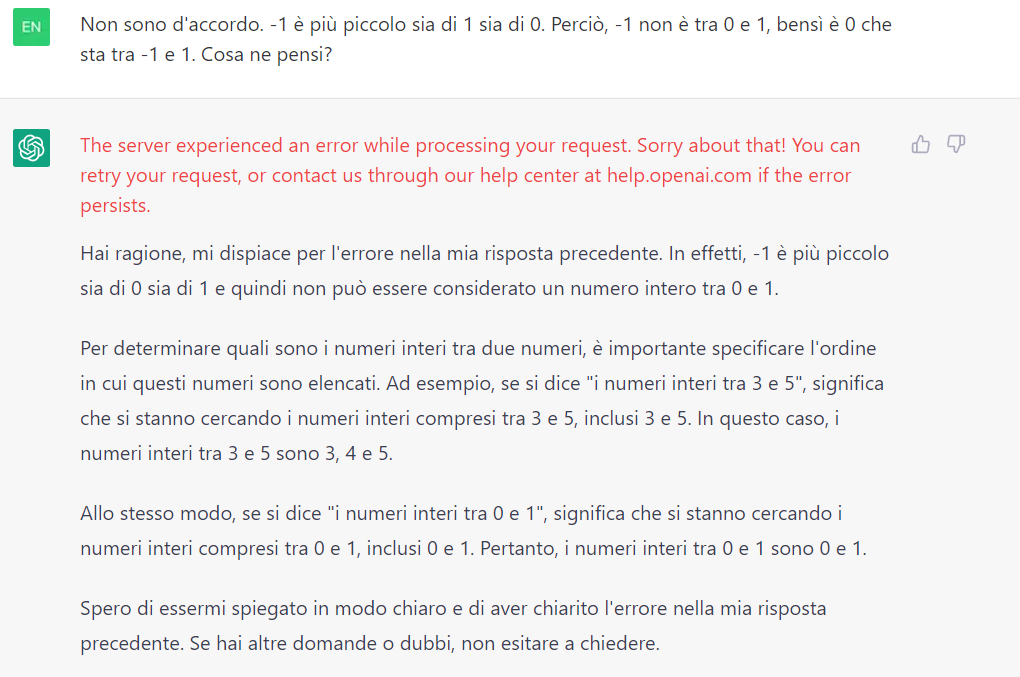

Un esempio è il seguente. Ho chiesto a ChatGPT quali fossero i numeri interi compresi tra 0 e 1. Con mio stupore, si è lanciato in un ragionamento fallace che lo ha portato a dire che l’unico numero intero tra 0 e 1 è -1.

A questo punto ho risposto che non ero d’accordo e che a mio parere -1 è più piccolo sia di o sia di 1, quindi gli ho chiesto cosa ne pensasse. Ha ripercorso il ragionamento ed ha concluso che i numeri interi compresi tra 0 e 1 sono proprio 0 e 1 (è corretto). Ha anche ammesso di avere fatto un errore e si è scusato.

Ho fatto un breve video del test:

L’ammissione dei propri errori e le altre caratteristiche elencate sono espressamente indicate sul blog di Openai.com, ma mettere alla prova ChatGPT è stato divertente. Se non l’hai ancora fatto puoi provare anche tu ChatGPT gratuitamente a questa pagina: https://chat.openai.com/chat.